0 引 言

随着工业化进程的不断推进,我国产业制造的不断转型升级,以及现代计算机技术的飞速发展,现代工业对自动化程度的要求越来越高,工业体系向着智能化的方向发展,人们对工业产品表面质量、精度以及可靠度的要求也越来越高。然而在提高生产效率的同时,产品的表面缺陷问题仍然不可避免。

目前,大多数铝型材生产企业仍采用传统的人工目测方式对铝型材表面进行缺陷检测,主观意识影响大,不仅效率低下而且稳定性差,容易产生误检、漏检等情况。传统的基于人工测量的表面缺陷检测越来越不能满足对铝型材产品检测精准度以及检测速度的要求。因此,基于机器视觉[1]、深度学习[2-3]的目标检测[4-5]技术应运而生,并且蓬勃发展。研究人员开始关注基于深度神经网络[6-7]的计算机视觉[8]算法来进行检测,两阶段检测模型有R-CNN[9]、SPP-Net[10]、Fast R-CNN[11]、Faster R-CNN[12-13]、R-FCN[14]、Mask R-CNN[15]等;单阶段检测模型有YOLO[16-18]系列、SSD[19]、DSSD[20]、FSSD[21]、RetinaNet[22]等。利用深度学习可以解决因铝型材表面缺陷种类多、成像不清晰、噪声干扰大、对比度低、纹理背景复杂、缺陷区域小和整体亮度不均匀等问题造成的检测困难,此外,利用深度学习对铝型材表面进行缺陷检测具有速度快,精准度高等特点。

基于机器视觉、深度学习的方法在工业缺陷检测领域有着良好的应用背景。李宇萌等人[23]基于机器视觉获取点云数据,对其进行预处理,提出了一种基于点云的转子表面缺陷检测方法;姚明海等人[24]结合边缘检测和模板匹配算法,提出了一种基于深度主动学习的磁片表面缺陷检测方法;魏若峰[25]基于深度卷积神经网络,提出了一种具有自适应、自学习特点的铝型材表面瑕疵检测网络;纪艳玲等人[26]提出了一种改进的K-means聚类分割和LVQ神经网络分类的方法,用于OLED显示面板缺陷像素的识别。

本文利用图像融合[27]与YOLOv3的方法,借鉴了SLAM[28]中特征提取与匹配的思想来检测铝型材表面缺陷,实现缺陷的特征提取、定位、自动分类和置信度输出。该方法不仅可以提高检测效率,还可以提升检测精度和准度,具有更强的特征提取能力和泛化能力。

1 缺陷检测方法

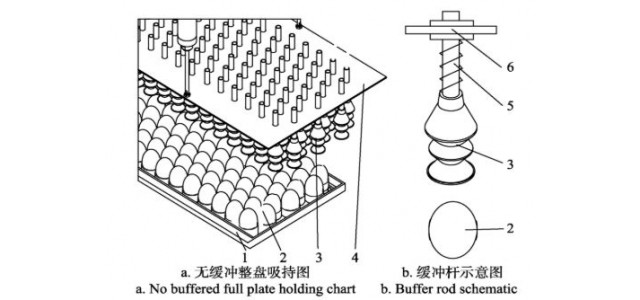

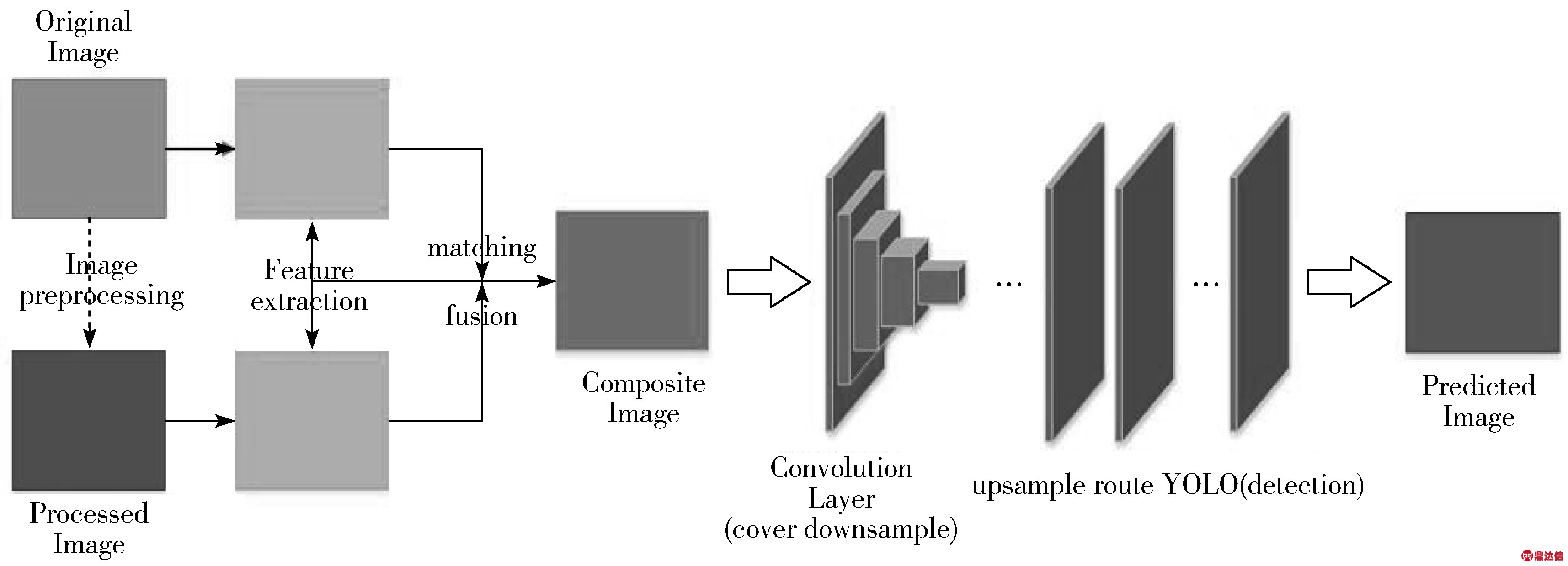

利用YOLOv3进行目标检测是近年来研究的热点,但对于不同的目标使用单一的YOLOv3方法往往并不能达到最优的效果。本文提出一种基于图像融合与YOLOv3的铝型材表面缺陷检测方法。其具体思想是:先对原始图像进行预处理,然后对原始图像和处理图像分别进行特征提取和对比匹配融合得到融合图像(即最终的处理后图像);再通过K-means算法聚类和调参优化,最后利用物体检测模型YOLOv3进行表面缺陷检测,得到预测的图像。其原理框架如图1所示。

图1 基于图像融合与深度学习的网络架构

1.1 图像融合

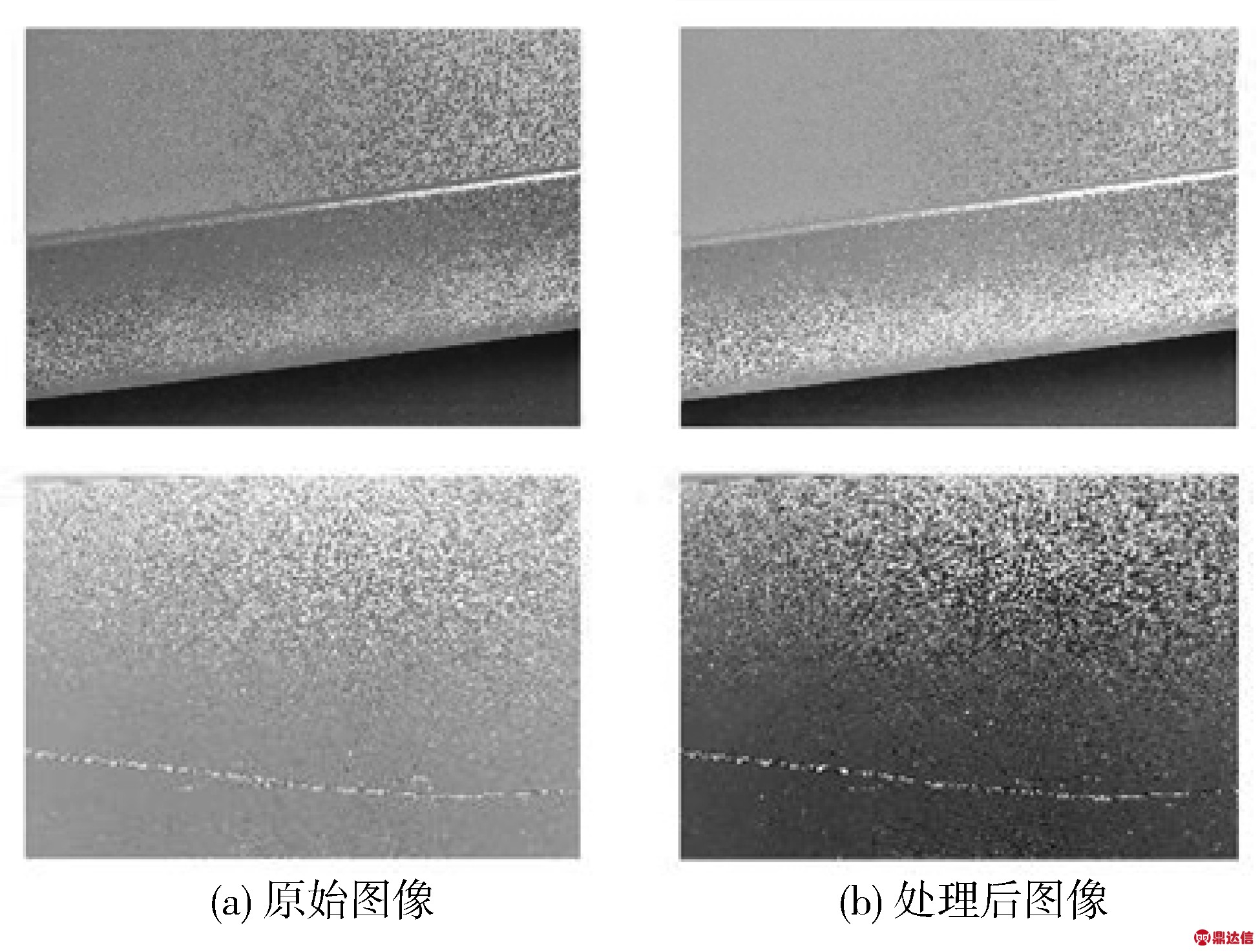

为了提高缺陷位置的像素值,充分曝光缺陷,让目标检测器更精准有效地训练与检测,利用灰度变换增强和空域滤波的方法对图像进行预处理得到处理图像,然后借鉴SLAM中特征提取与匹配的思想,对原始图像和处理图像进行对比匹配融合得到最终的处理后图像。考虑到每幅图像特征位置、形状、大小等不同,为保证实验结果精确,分别对所有样本进行一一处理。

1.1.1 灰度变换增强

矮化抗倒伏对往年倒伏严重且长势旺的麦田,建议喷施矮壮素或助壮素(50%矮壮素50mL,兑水30kg喷施),可有效地抑制节间伸长,使植株矮化,茎基部粗硬,从而防止倒伏[4]。

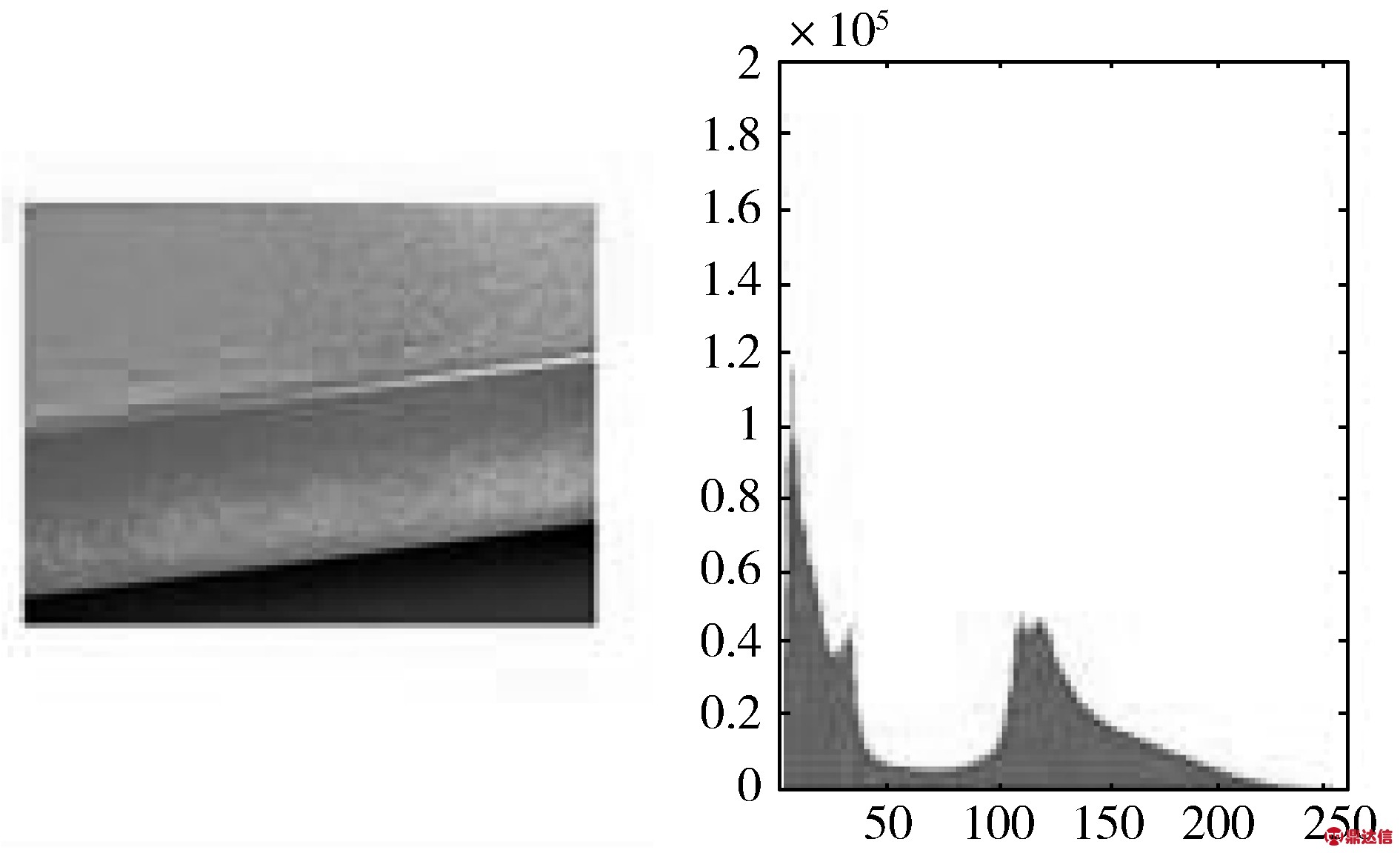

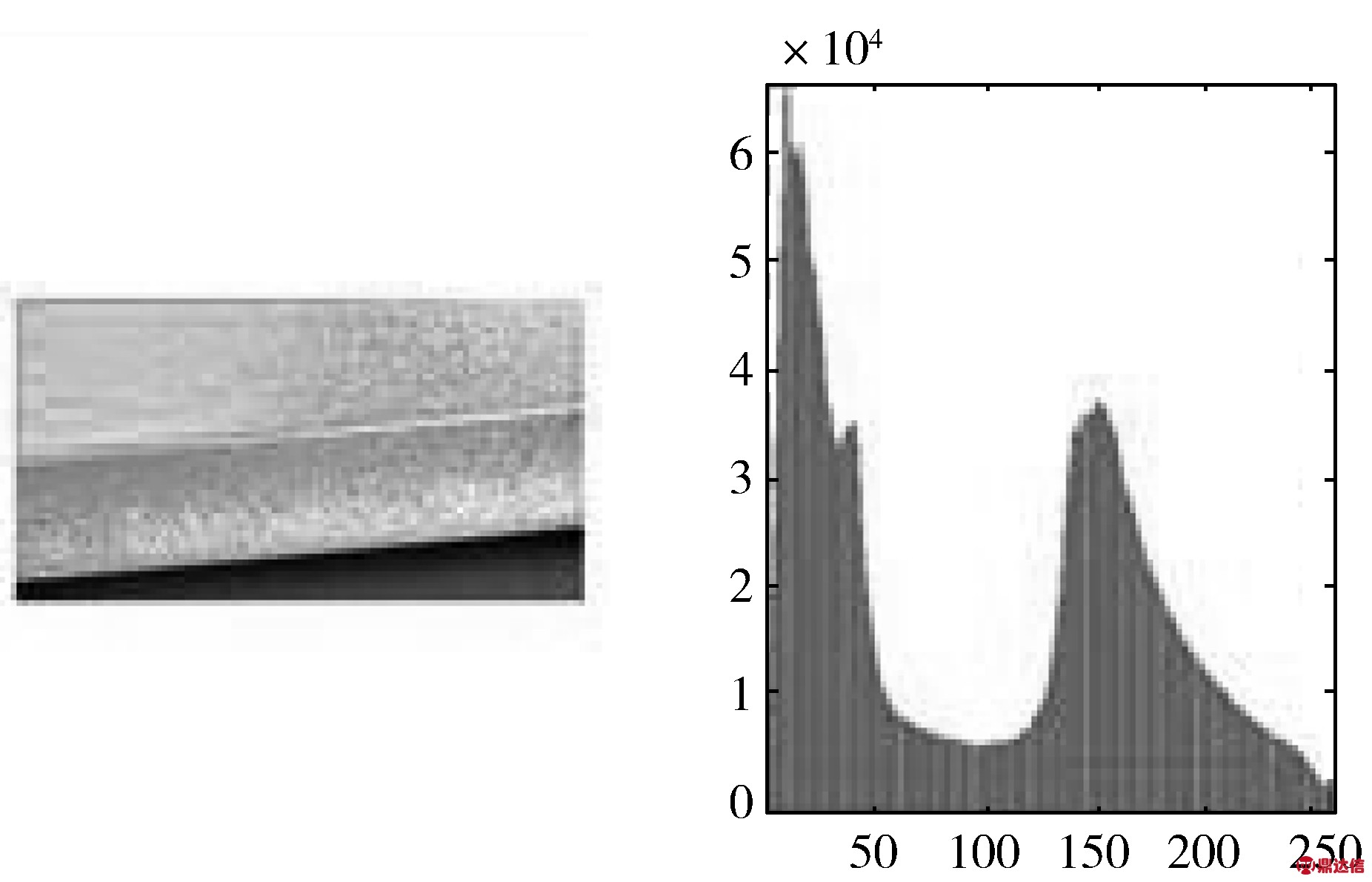

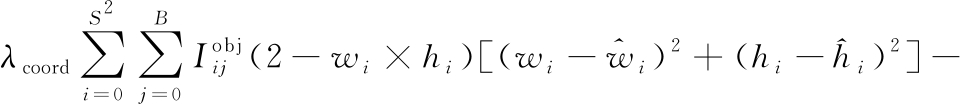

如图2所示,因各类样本特征信息不同,这里仅做出了2类样本(不导电和擦花)灰度变换增强的过程作为代表(下同)。先获取原始图像的灰度图像直方图,得出灰度值集中分布的区间(a,b),再通过公式(1)变换将灰度值尽可能地均匀分布在0~255之间,让图像变得更加清晰,得到增强后的图像及灰度图像直方图。

(1)

其中,x为a和b之间的灰度值,y为0~255之间的灰度值。

(a) 不导电原始图像及灰度图像直方图

(b) 不导电增强后的图像及灰度图像直方图

(c) 擦花原始图像及灰度图像直方图

(d) 擦花增强后的图像及灰度图像直方图

图2 灰度变换增强

1.1.2 空域滤波

如图3所示,采用模板和图像的领域相卷积的方法来进行空域滤波。先读入灰度图像,然后通过imnoise函数添加椒盐噪声,建立线性滤波模板,最后通过imfilter函数进行平滑滤波,得到相应滤波后的图像。

毫米波频率步进雷达是一种高分辨宽带雷达,具有瞬时带宽小、抗干扰能力强等特点[1]。然而,频率步进雷达存在着严重的距离-多普勒耦合问题,即运动目标的距离像将呈现出发散、移位等现象,因此如何进行运动补偿成为利用频率步进信号处理运动目标的关键[1]。

图3 空域滤波

1.1.3 特征提取与匹配

特征提取与匹配如图4所示。

(a) 特征点提取

(b) 筛选后的最优特征匹配点对

图4 特征提取与匹配

图4借鉴了SLAM(Simultaneous Localization And Mapping)中特征提取与匹配的思想来处理图像。先找出原始图像和处理图像的像素特征点,再借鉴SIFT(Scale-Invariant Feature Transform)特征提取思想进行关键点描述与提取,找出缺陷位置像素信息的SIFT特征,然后对像素信息突出的相同位置(人工选取)特征点进行匹配,并返回匹配点对。最后用基础矩阵F(F是一个3×3的矩阵,表达了立体像对的像点之间的对应关系)过滤匹配的特征点对,画出匹配特征点的连接线。之后对匹配点对设置一个阈值(大于2倍最小距离即视为误匹配,因每张样本特征信息不同,最小距离不固定)进行匹配筛选,保留最优的特征匹配点对。

1.1.4 特征融合

果敢不凡的宝石装饰、熠熠生辉的莳绘漆艺表盘,Divas’ Dream超薄三问腕表由精湛工艺打造,集百年制表与珠宝艺术之大成,奏响赞颂华美技艺的典雅鸣音。这款Divas’ Dream超薄三问女士腕表拥有最纤薄的三问报时机心——Finissimo。它是基于在2016年巴塞尔国际钟表珠宝展上亮相的Octo Finissimo超薄三问腕表机心打造的升级版本。这款创纪录的精良机心由BVLGARI宝格丽位于瑞士的Le Sentier表厂研发制造。

在第一梯队中,四川省在各层次均排在第1位,重庆市在基础层、融合层、新生层和福利层四个层次排名第2位,在传输层屈居第3位,陕西省在基础层排名第6位,在传输层跃居第2位,超过重庆市,在融合层、新生层和福利层三个均仅次于四川和重庆位于第3。四川省和重庆市在总指数上遥遥领先,陕西省紧随其后,三省份在西部地区信息经济发展中处于优势地位。四川省和重庆市在融合型信息经济方面优势突出,但是重庆市的基础型信息经济落后于四川,陕西省在基础型信息经济层面底子薄弱,在一定程度上制约了其整个信息经济的发展。

特征融合过程如图5所示。

第一行依次为原始图像、灰度图、HSV图、单通道图、单通道深度图、RGB深度图;

第二行依次为处理图像、灰度图、HSV图、单通道图、单通道深度图、RGB深度图;

第三行依次为最终的处理后图像、灰度图、HSV图、单通道图、单通道深度图、RGB深度图。

图5 特征融合过程图

图5依次作出了原始图像和处理图像的灰度图、HSV图、单通道图、单通道深度图、RGB深度图等得到关键特征(人工选取)信息。结合特征提取与匹配的关键特征信息,利用图像融合中亮度调整后按距离比例融合的方法,获取两图关键特征信息,得出重合部分,并转化为亮度图,把每点的亮度值相加,舍弃冗余特征,保留最优特征信息(关键特征交并比值及距离权重)进行特征互补融合,得到最终的处理后图像,并作出了它的灰度图、HSV图、单通道图、单通道深度图、RGB深度图。

深秋已到,雁群南飞,凉风阵阵。一天,杨力生去二里地外一个镇上赶集,在集上,见有人卖新鲜牛肉,便随意买了四斤。他想,自己把这四斤牛肉一分两份,自己留下二斤拿回家,另外二斤便送给父母,让父母也尝尝鲜牛肉的味道。忽然想起媳妇与父母的矛盾。心想:这事要是让杨秋香知道,肯定两口子又要大吵起来,无奈,只得背着杨秋香把二斤牛肉送给了父母。不料,这天杨秋香到吴玉梅家和几个女伴玩扑克,到中午,正从另一条胡同回家,走到胡同口时,远远便看到杨力生提着二斤牛肉进了公婆的家,而杨力生却未看见她。回到家后,杨秋香心里的怒气不打一处来,脸拉得有二尺长,歪着头质问杨力生:“杨力生,你今天是不是送牛肉给你爹妈了?”

1.1.5 处理后图像尺寸调整

原始图像的像素为2560×1920,为保证对照实验结果精确,在不改变特征信息的前提下,处理后图像的像素也调整为2560×1920。

1.2 YOLOv3网络模型

1.2.1 特征提取器

YOLOv3特征提取器在YOLOv2的Darknet-19基础上做了优化,命名为Darknet-53,比ResNet-101更好。包含52层卷积层和1个全连接层,加入了多个连续的1×1和3×3的卷积,借鉴了ResNet网络的残差结构,使用该结构可以让网络结构变得更深(YOLOv2的Darknet-19没有残差结构,YOLOv3的Darknet-53有残差结构),增加直接连接,并且网络层数达到53层。各模型框架在ImageNet数据集上特征提取效果如表1所示。

表1 模型框架在ImageNet上的效果对比

BackboneTop-1Top-5Bn OpsBFLOP/sFPSDarknet-1974.191.87.291246171Darknet-5377.293.818.7145778ResNet-10177.193.719.7103953

1.2.2 多尺度预测

在结果的预测上,YOLOv3使用了3个尺度,包括1个feature map为13×13的下采样,以及2个feature map分别为26×26、52×52的上采样。YOLOv3的416×416用了52个feature map,主要是为了提高小目标的识别能力。

1.1 一般资料 2015年7月至2017年7月上海交通大学医学院附属第九人民医院眼科共收治1 053例拟行手术治疗的先天性上睑下垂患者,每例患儿术前均常规行超声心动图检查。排除其他原因引起的上睑下垂,包括:(1)外伤性上睑下垂、腱膜性上睑下垂;(2)全身性疾病(如重症肌无力等)引起的上睑下垂;(3)有上睑下垂表现的综合征,如小睑裂综合征、下颌瞬目综合征、唐氏综合征等。本研究经医院伦理委员会审核批准,患者及家属知情同意并签署知情同意书。

YOLOv3每个位置预测3个bounding box,也就是anchors_num值为3,而在YOLOv2中会为每个bounding box预测5个坐标(tx,ty,tw,th,to)。另外有N个classes+4个coords+1个objectness,所以每个位置输出(N+4+1)×3个值,这就是每个尺度张量的深度,即cfg中的filters值。

1.2.3 K-means算法

使用K-means算法在整个尺度上均匀分割聚类得到anchor boxes来确定边界框的预测,对数据集重新进行聚类。K-means算法是典型的基于距离的聚类算法,采用距离作为相似性的评价指标。可以表示为将给定样本集D={x1,x2,…,xn}划分为G={G1,G2,…,Gk}的过程,每个划分好的簇中的各点,到G的质心μk的距离平方之和称为误差平方和,即SSE(Sum of Squared Error)为:

(2)

因此K-means算法应达到G1,G2,…,Gk内部的样本相似性大、簇与簇之间的样本相似性小的效果,即尽可能减少SSE的值。当k小于真实聚类数时,SSE下降幅度很大,而当k接近于真实聚类数后,SSE下降幅度明显减缓。

图6 k-SSE关系图

以上为k值与SSE关系变化图,使用手肘法可知当k=9时为最优解。因为K-means初始点敏感,所以每次运行得到的anchor值不一样。本文经过不同方法多次计算,得出了最优的anchor值。即为9个聚类:(15×38)、(26×132)、(89×36)、(116×52)、(138×127)、(205×55)、(327×27)、(404×102)、(406×58)。计算得出这组anchor在数据集上的avg iou为75.45%,比YOLOv3原始的9个聚类在数据集上得出的avg iou值要高得多。

2 实验过程

2.1 实验装置与模型框架

使用Nvidia GeForce GTX 1080Ti和Nvidia TITAN Xp来训练和检测模型,使用Ubuntu16.04, 64位操作系统,使用Darknet深度学习框架与主干网络为Darknet53的YOLOv3模型来进行实验。

2.2 实验数据集制作

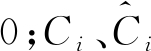

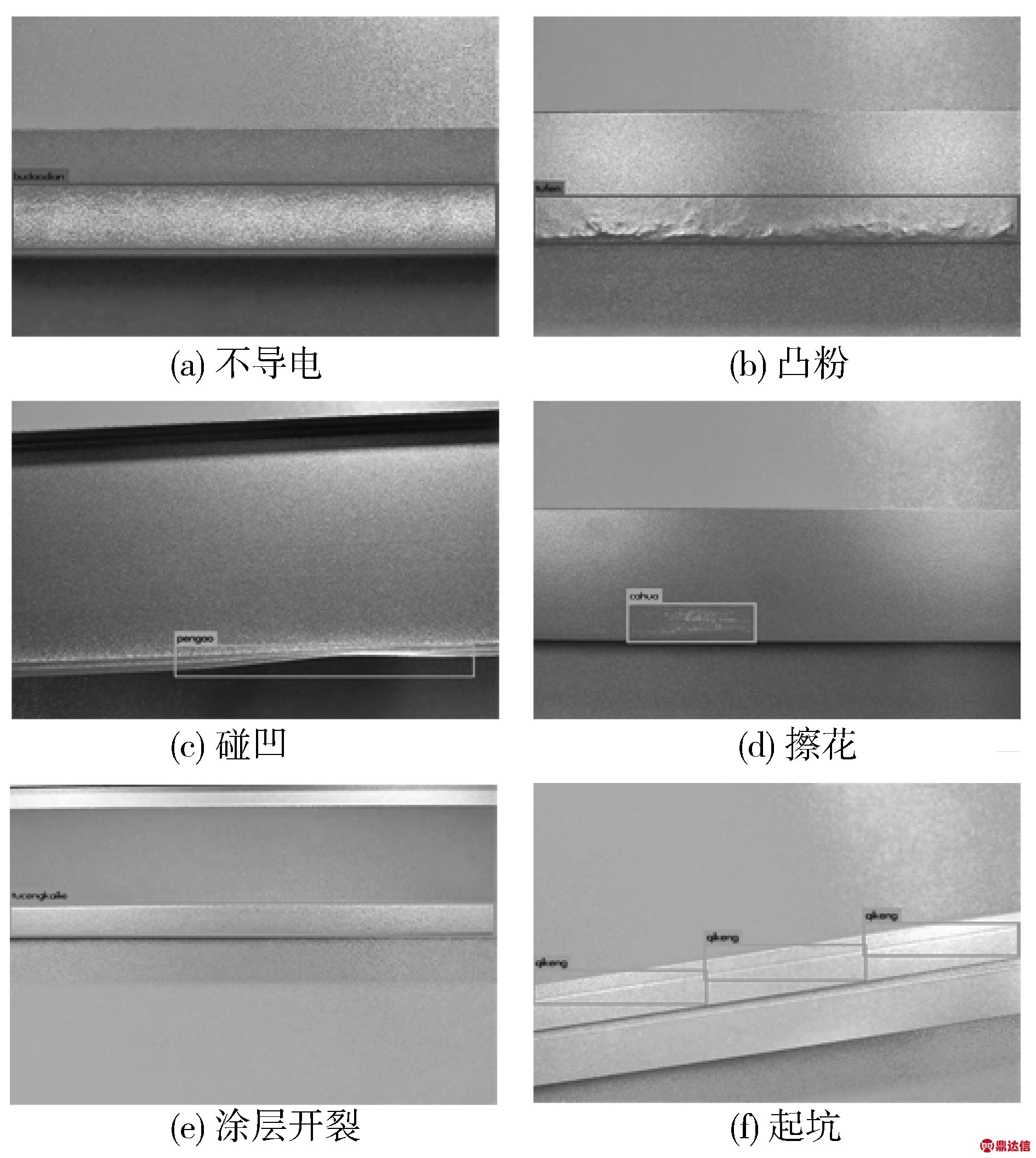

原始图像1200幅,其中训练集1080幅图像,验证集120幅图像(验证集1)。处理后图像1200幅,其中训练集1080幅图像,验证集120幅图像(验证集2)。共计2400幅图像进行实验,其中训练集2160幅图像,验证集240幅图像(验证集3)。将缺陷分为不导电(budaodian)、凸粉(tufen)、碰凹(pengao)、擦花(cahua)、涂层开裂(tucengkailie)、起坑(qikeng)等6类。然后利用标注工具分别对原始图像和处理后的图像进行标注,制作成数据集,供后续神经网络训练使用。

图7 原始图像和处理后图像

2.3 模型训练与检测

采用Darknet深度神经网络框架和YOLOv3模型,实现缺陷特征的精确提取与定位、准确分类以及提高置信度。为保证实验结果客观公正,采用按不同类别样本数量比例随机抽样数据来进行训练和检测。

第二,利用住房公积金合理避税。依据《公积金管理办法》,每月所交纳的住房公积金是从税前扣除的,也就是说住房公积金是不用纳税的,所以员工可以多交或补充缴纳住房公积金,通过增加自己的住房公积金来降低工资总额,从而减少应当缴纳的个人所得税,达到合理减税、避税目的。

3 实验结果及分析

使用主干网络为Darknet53的YOLOv3模型训练,使用在ImageNet数据集上预先训练的Darknet53模型卷积权重。使用Pascal VOC 2007数据集制作实验数据集,然后利用迁移学习的方法对实验数据集进行迭代训练,利用最后获得的权重参数来检测验证集图像。图8为图像融合与深度学习方法检测验证集的实验结果。

图8 实验结果

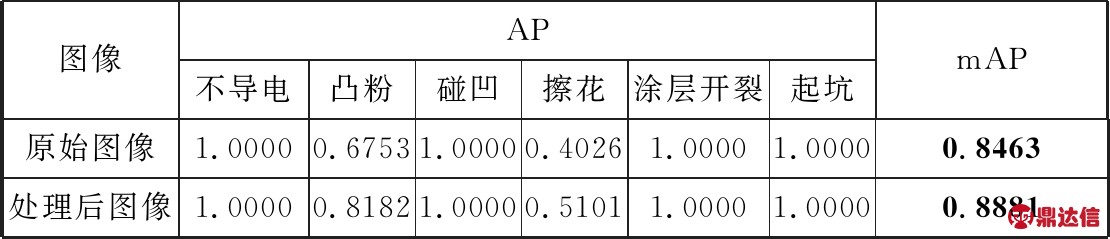

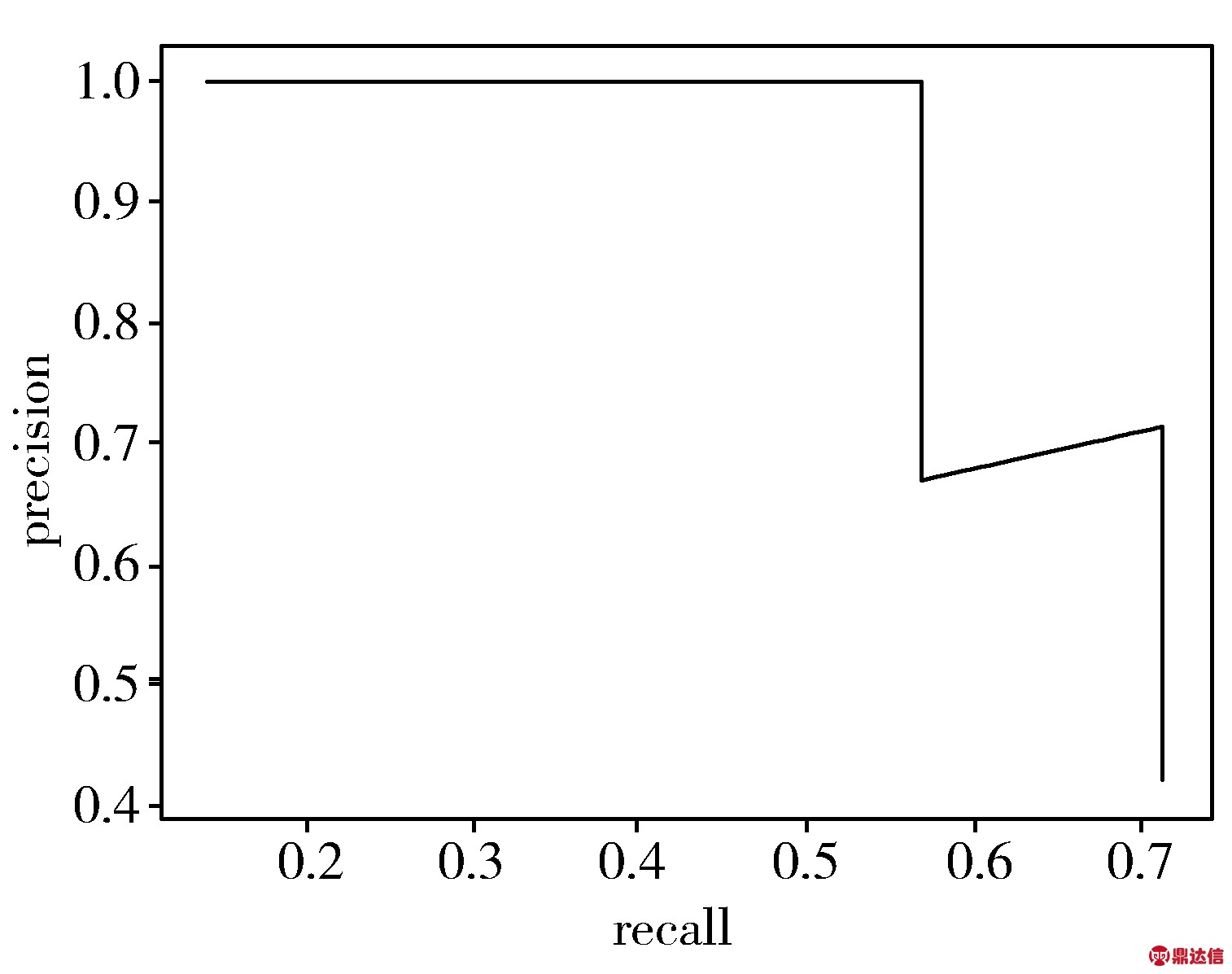

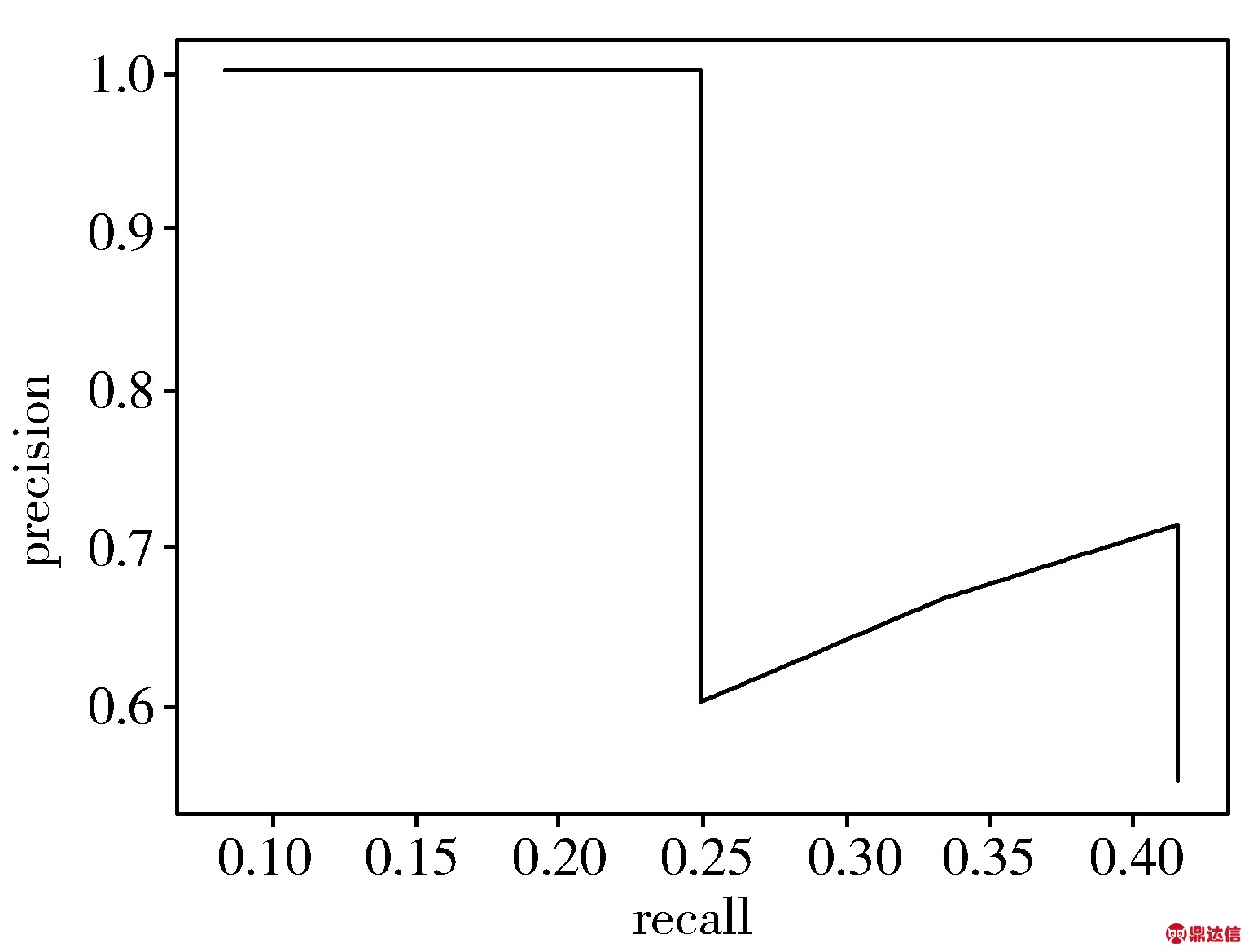

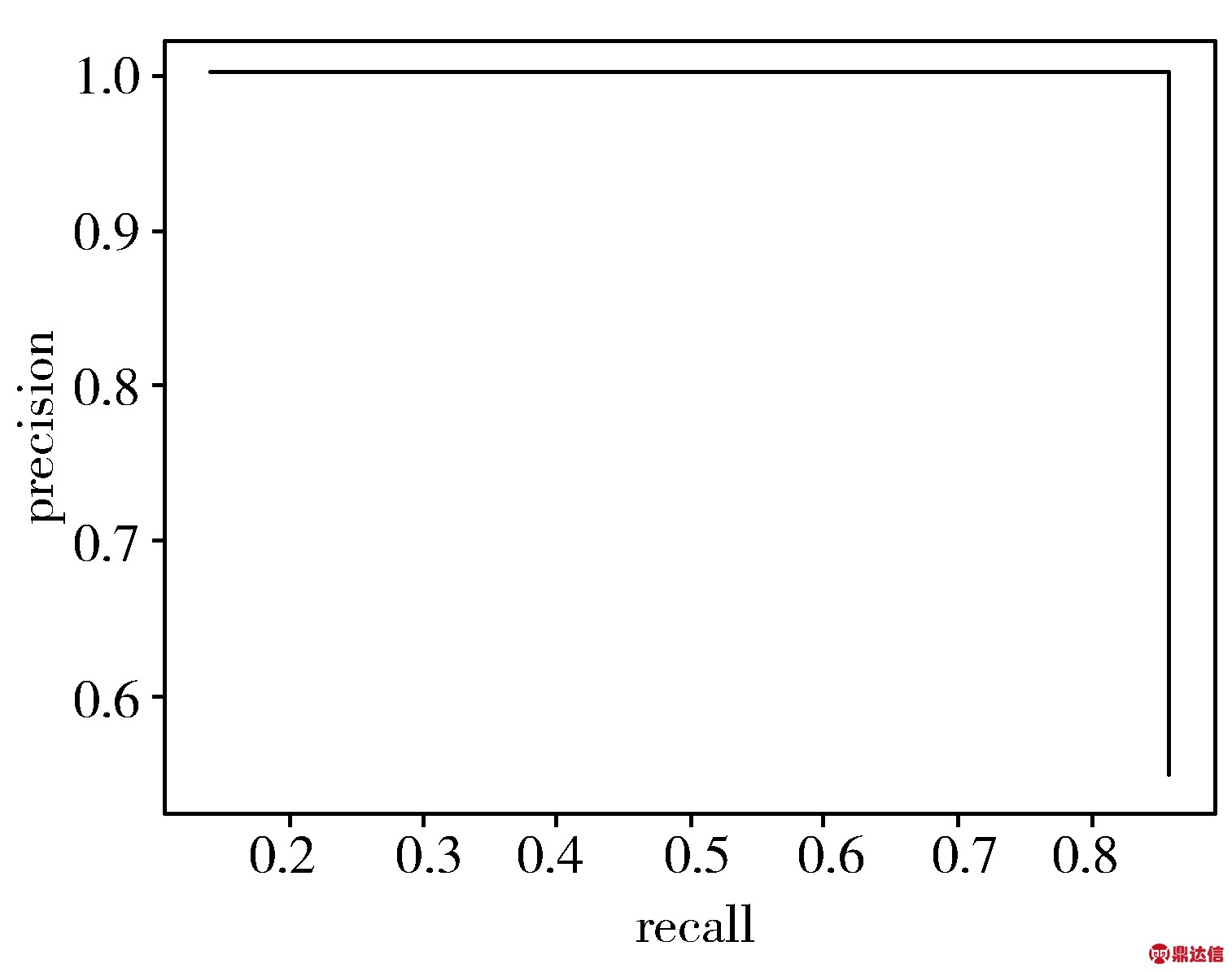

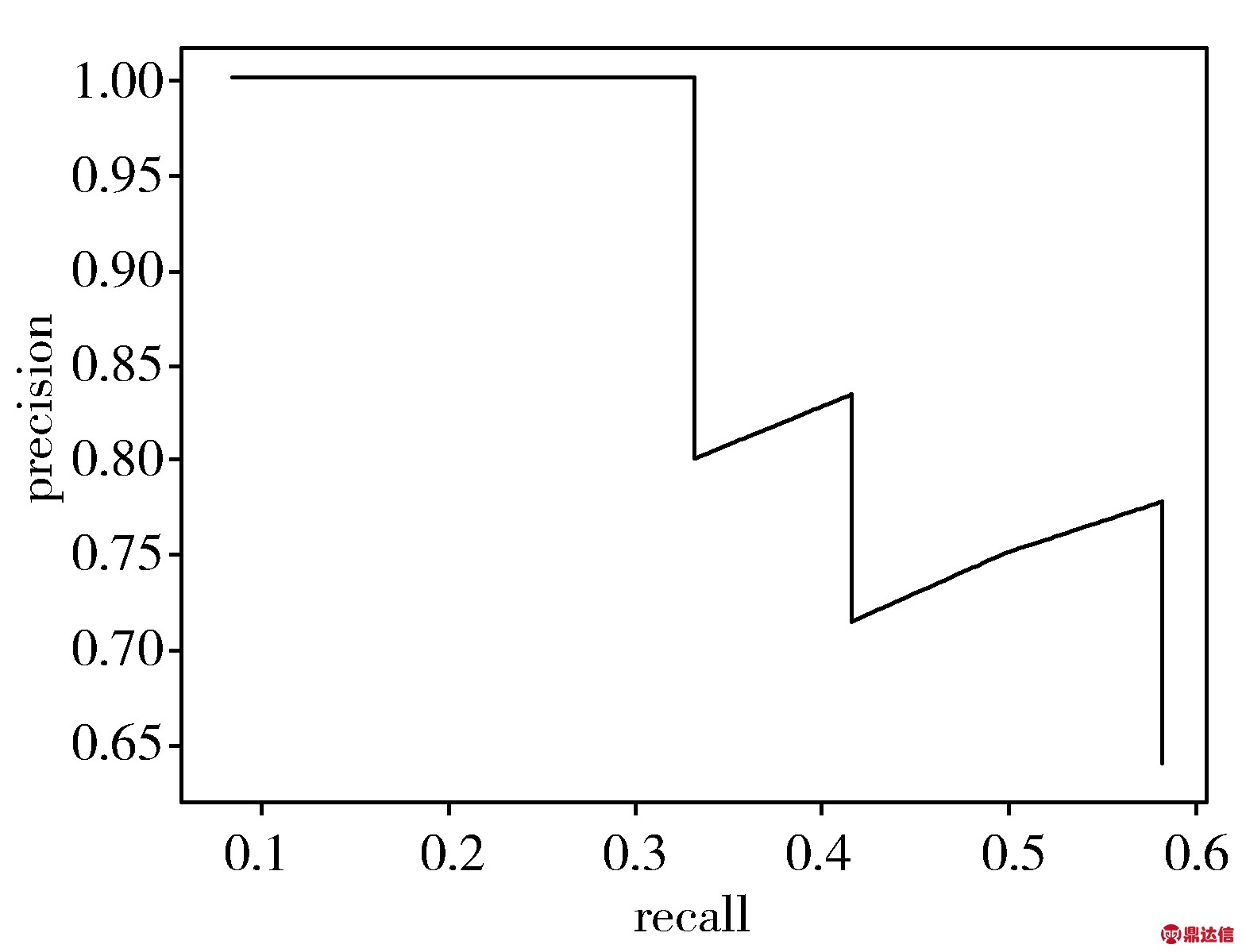

根据实验结果可知,该方法能精确检测表面缺陷,并实现分类和定位。计算得出2种模型下各分类的AP值、mAP值以及对验证集的检测成功率,并且作出了P-R曲线来做比较。P-R曲线即为精确率precision(指的是在所有预测为正例的数据中,真正例所占的比例)和召回率recall的关系曲线。

表2 AP值及mAP值对比

图像AP不导电凸粉碰凹擦花涂层开裂起坑mAP原始图像1.00000.67531.00000.40261.00001.00000.8463处理后图像1.00000.81821.00000.51011.00001.00000.8881

表3 检测成功率对比

图像成功率/%验证集1验证集2验证集3(平均)原始图像95.0094.1794.58处理后图像98.3398.3398.33

从表2、表3可知,在验证集中,处理后图像模型对表面缺陷分类检出的平均成功率为98.33%,比原始图像模型提高了3.75个百分点;验证集mAP值为88.81%,比原始图像提高了4.18个百分点,取得了较为理想的效果。各种缺陷检测的P-R曲线图如图9所示。

第一行3幅图像依次为原始图像不导电、凸粉、擦花的P-R曲线图;第二行3幅图像依次为处理后图像不导电、凸粉、擦花的P-R曲线图。

图9 原始图与处理后图的各种缺陷检测的P-R曲线图

根据图9可知,处理后图像的P-R曲线都可以完全包围住原始图像的P-R曲线,面积都更大。说明了处理后图像得到的模型比原始图像得到的模型更精确,性能更优越。

预制装配式混凝土结构有多种形式,如剪力墙结构,框架结构,框架剪力墙结构和部分框架剪力墙结构。由于预制装配式结构的预制构件全部通过连接节点连接,所以混凝土结构在大范围内尚未广泛使用。与传统建筑方法相比,预制建筑物具有更多的连接界面和接缝,而装配式混凝土结构中的节点是装配式建筑的薄弱环节,在连接节点的处理问题上,国内的技术手段目前并不是很成熟。但装配式建筑结构在环保、节能和施工上与现浇相比优点比较突出。

4 相关评估指标分析

4.1 Loss、IOU曲线

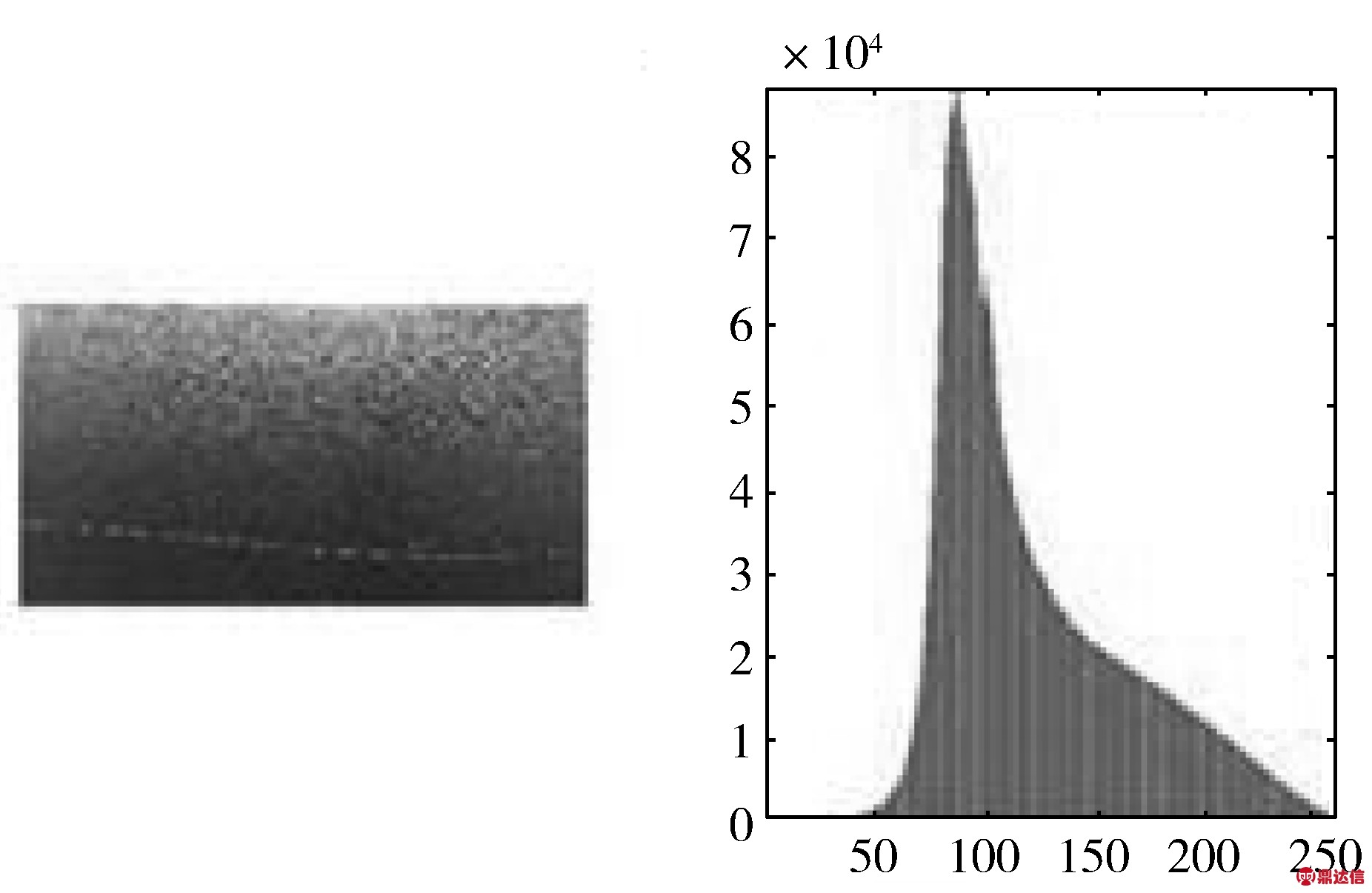

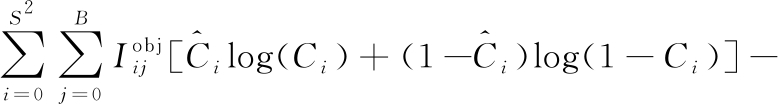

Loss使用了均方和误差作为损失函数,由3个部分组成:坐标误差、IOU误差和分类误差,计算公式如下:

(3)

其中,λcoord表示协调系数;S2表示总共S×S个网格,每个网格产生B个候选框![]() 表示第i个网格第j个anchor box是否负责预测这个物体,若是其值为1,否则为0;xi、yi、wi、hi分别表示真实矩形框的中心点坐标及宽高;

表示第i个网格第j个anchor box是否负责预测这个物体,若是其值为1,否则为0;xi、yi、wi、hi分别表示真实矩形框的中心点坐标及宽高;![]() 分别表示预测矩形框的中心点坐标及宽高;λnoobj表示权重值;

分别表示预测矩形框的中心点坐标及宽高;λnoobj表示权重值;![]() 表示第i个网格第j个anchor box是否不负责预测这个物体,若是其值为1,否则为

表示第i个网格第j个anchor box是否不负责预测这个物体,若是其值为1,否则为![]() 分别表示预测值和真实值的参数置信度;

分别表示预测值和真实值的参数置信度;![]() 分别表示某类别的预测值概率及真实值概率。

分别表示某类别的预测值概率及真实值概率。

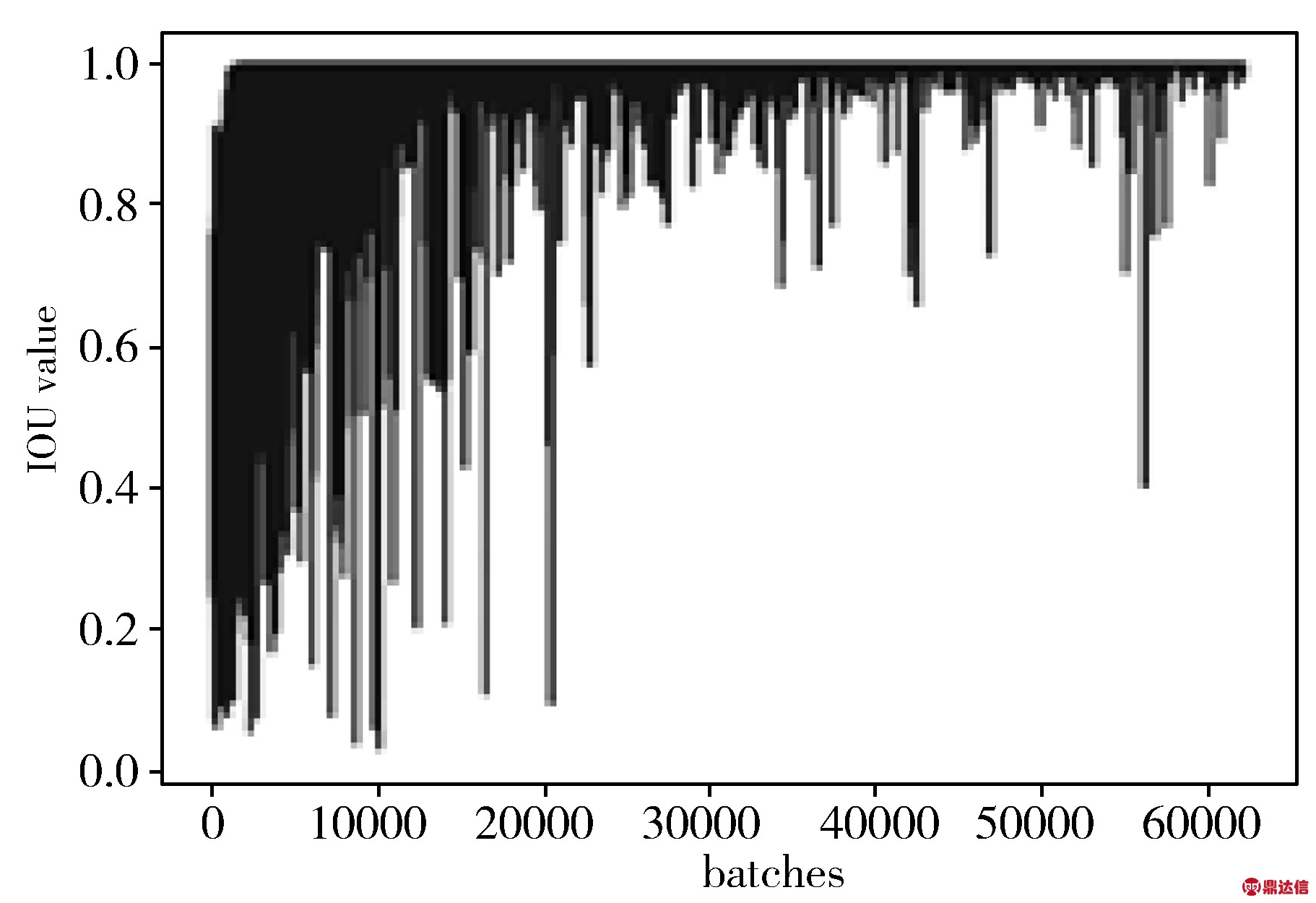

IOU为预测框与实际框的交集面积与并集面积之比,即:

(4)

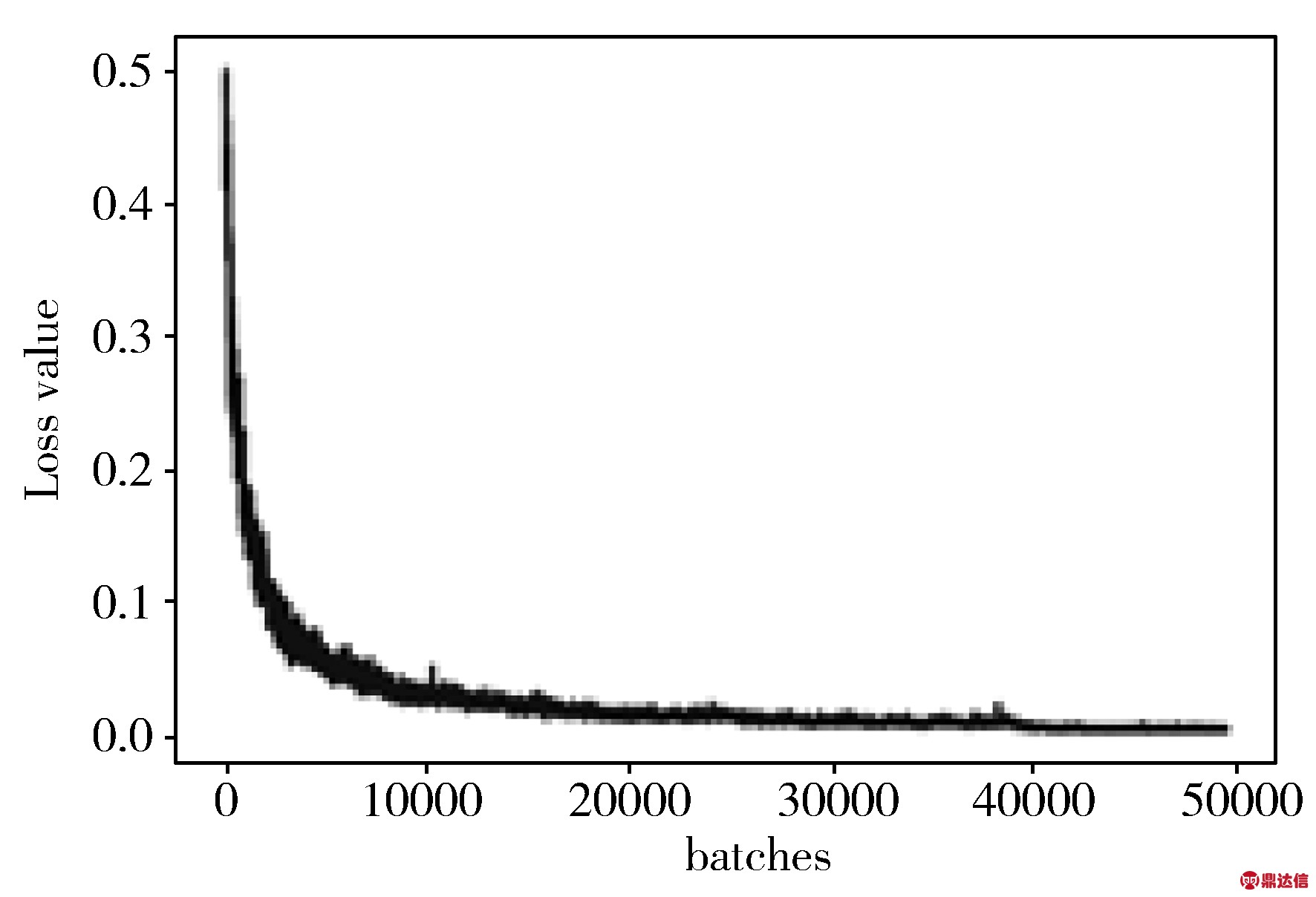

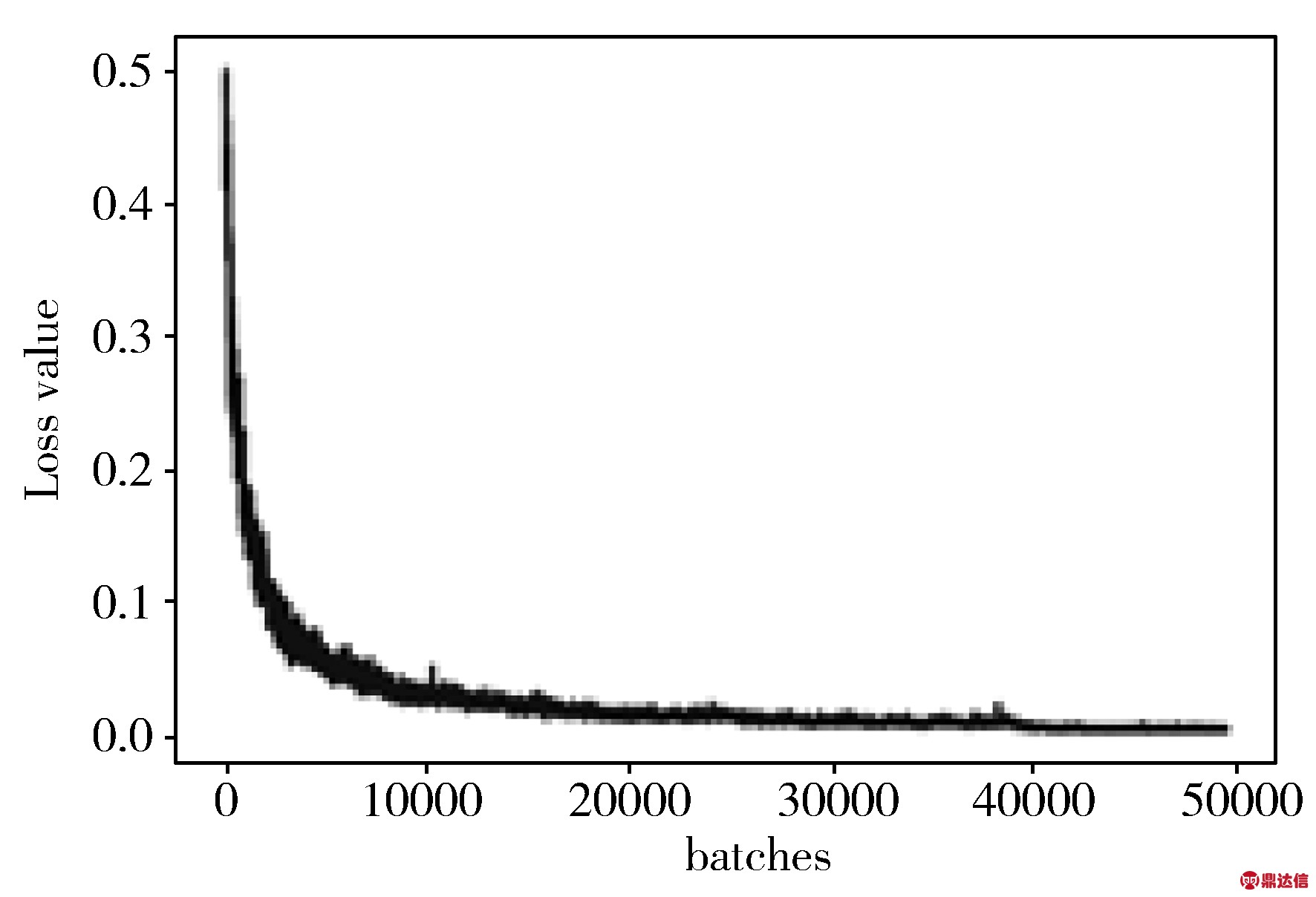

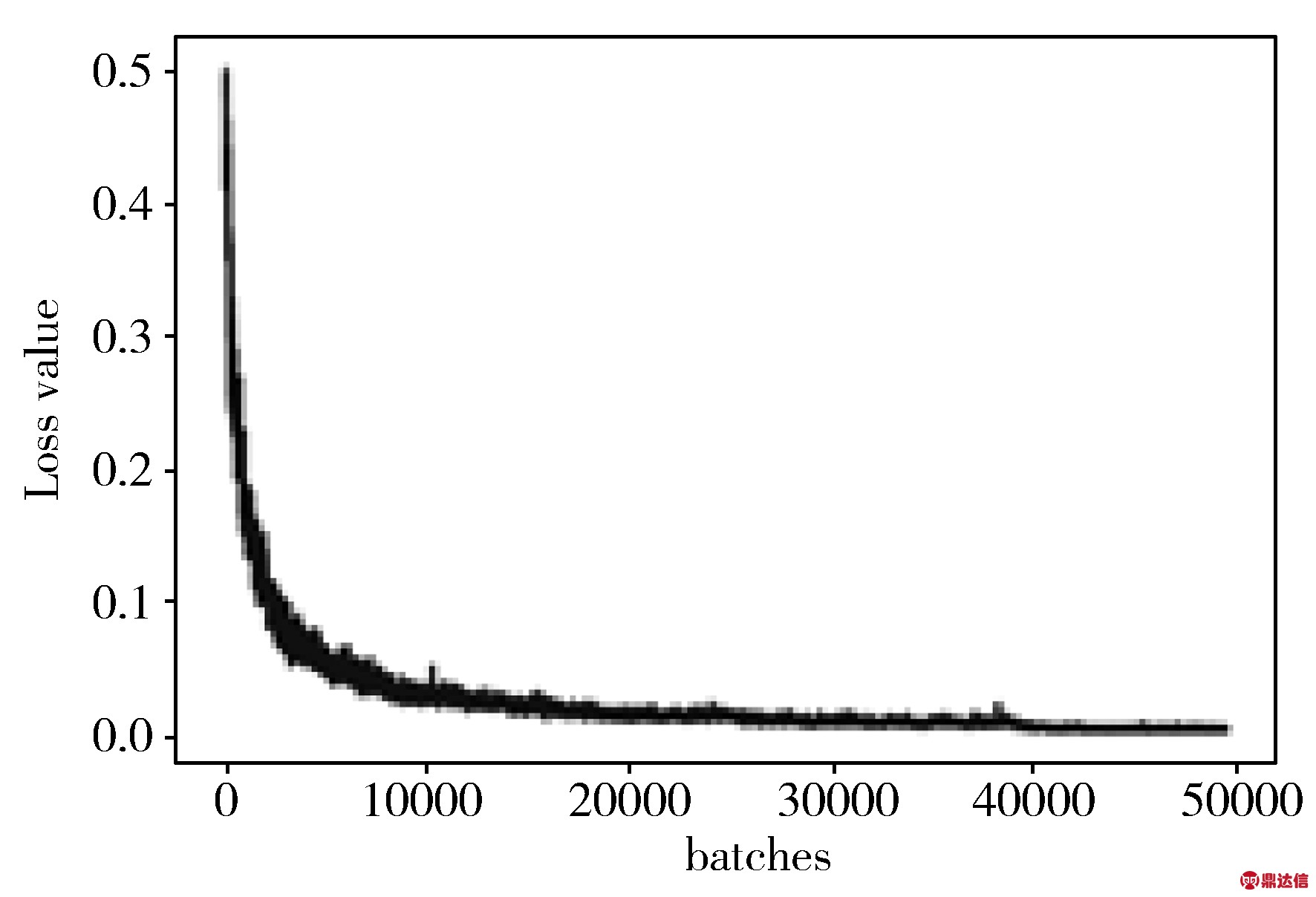

原始图像与处理后图像的Loss曲线及IOU曲线对比如图10所示。

(a) 原始图像的Loss曲线

(b) 处理后图像的Loss曲线

(c) 原始图像的IOU曲线

(d) 处理后图像的IOU曲线

图10 原始图像和处理后图像的Loss和IOU对照图

从图10可知,处理后图像得出的Loss曲线比原始图像得出的Loss曲线随着迭代次数的增加振荡幅度更小,更趋于平缓。处理后图像得出的IOU曲线比原始图像得出的IOU曲线随着迭代次数的增加波动范围更小,能够快速收敛,这些都表明了处理后图像模型更稳定,性能更好。

尽管国际经济出现复苏,但全球性贸易仍然继续震荡,欧元区经济增速放缓,新兴市场经济动荡加剧,加上西方一些国家所设的各种经济壁垒,国际林产品市场竞争激烈,我国木材制品出口仍较困难。随着“一带一路”倡议的推进,深圳、成都、郑州等多个城市相继开通中欧班列,由于班列运输时间比海运缩短三分之二,价格是空运的四分之一,因而加速我国木材加工产品对“一带一路”沿线国家的出口速度,前3季度我国的刨花板和胶合板出口数量都实现了增长。纤维板的出口数量下降不少,但出口金额降幅收窄,木家具出口数量有增长,但出口金额基本与去年同期持平。

4.2 Recall、Recall-IOU曲线

Recall为召回率:

(5)

其中,TP为将正类预测为正类数,FN为将正类预测为负类数。

对安戈夫方法进行运用的过程中,也需要组间专家小组。随后,专家小组各成员均要设想一批考生处于某等级临界位置,并对所有考生进行逐一估计,确定能够正确解答试题考生的数量,并对临界位置考生能够正确解答不同试题的人数比重进行计算。在此基础上,对此等级要求标准进行计算,即可获得分数线。若有六名专家针对测试题展开三次评定,且测试题的数量是10个。而现象处于临界位置的考生数量是100名。根据安戈夫方法进行计算,良好等级最低的得分几率是82.09%。所以说,上述10道题的试题测验,良好等级的标准就是8.2。所以,对良好等级标准进行设定,即可确定为8分。

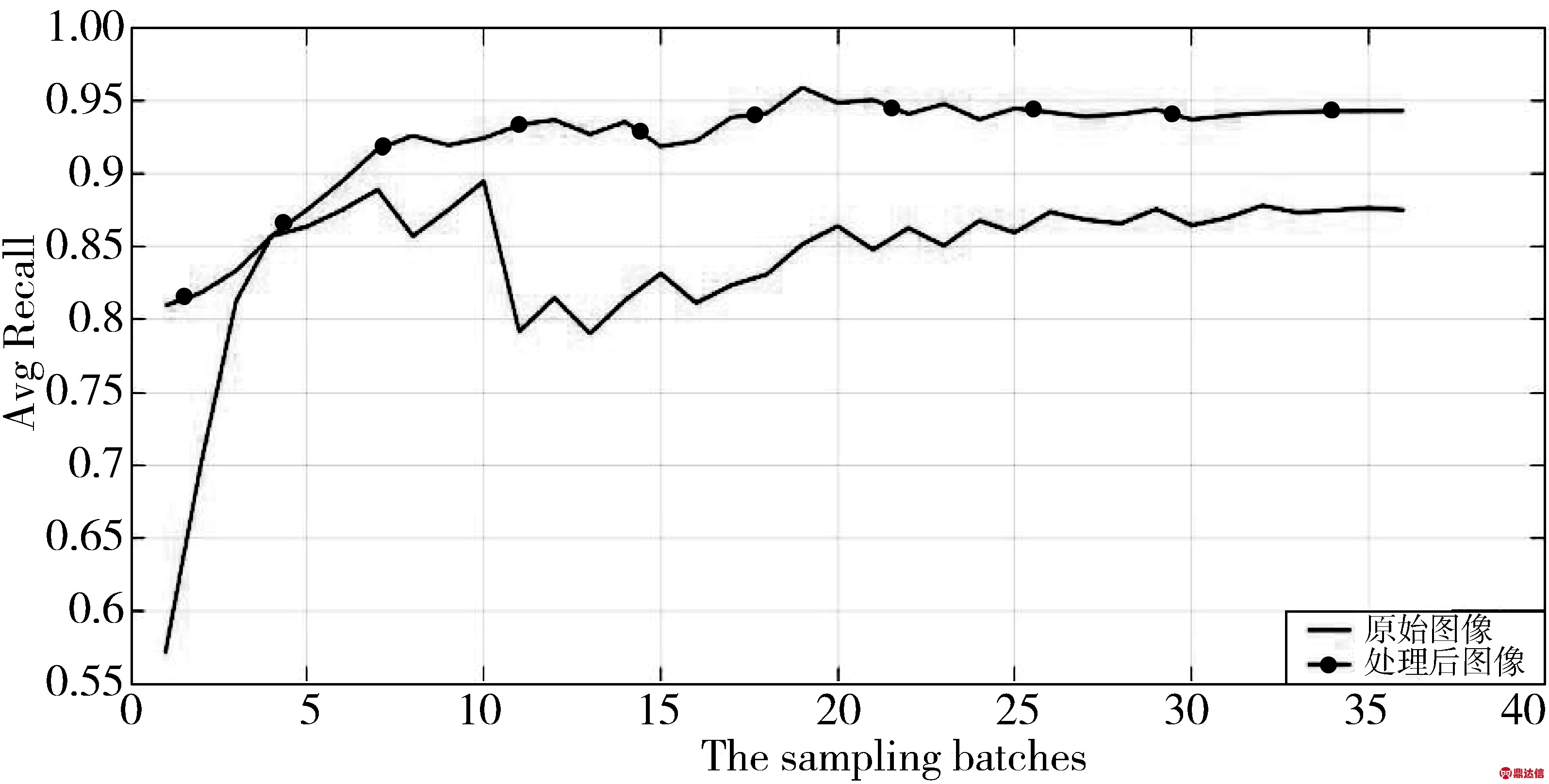

图11 原始图像和处理后图像的Avg Recall对照图

按比例每隔30幅图像抽样,共36批次1080幅图像,分别计算得出原始图像和处理后图像的Avg Recall,并作出图11。从图11可知,处理后图像得出的曲线比原始图像得出曲线总体Avg Recall值要高得多,而且波动范围更小,后期逐渐趋于稳定,所得出的模型性能更好。

最低IOU阈值设置为0.6,依次上涨0.025个单位,作出了原始图像和处理后图像的Recall-IOU对照图,如图12所示。从图12可知,原始图像模型在IOU≤0.65时,Recall基本上接近于1;当IOU>0.65后不断下降。处理后图像模型在IOU≤0.7时,Recall基本上接近1;当IOU>0.7后不断下降。同时处理后图像模型下降幅度比原始图像模型更缓慢、更平稳。并且当IOU阈值一定时,处理后图像模型比原始图像模型的Recall值都要高,表明处理后图像模型效果更好,性能更优越。

怪不得叫“雅治奶茶店”。是个日本人。我忘了擦挂在我眼角的眼泪,想起来后就在脸上用手一顿乱抹。他递给我一张面巾纸。我胡乱地擦了擦。

图12 原始图像和处理后图像的Recall-IOU对照图

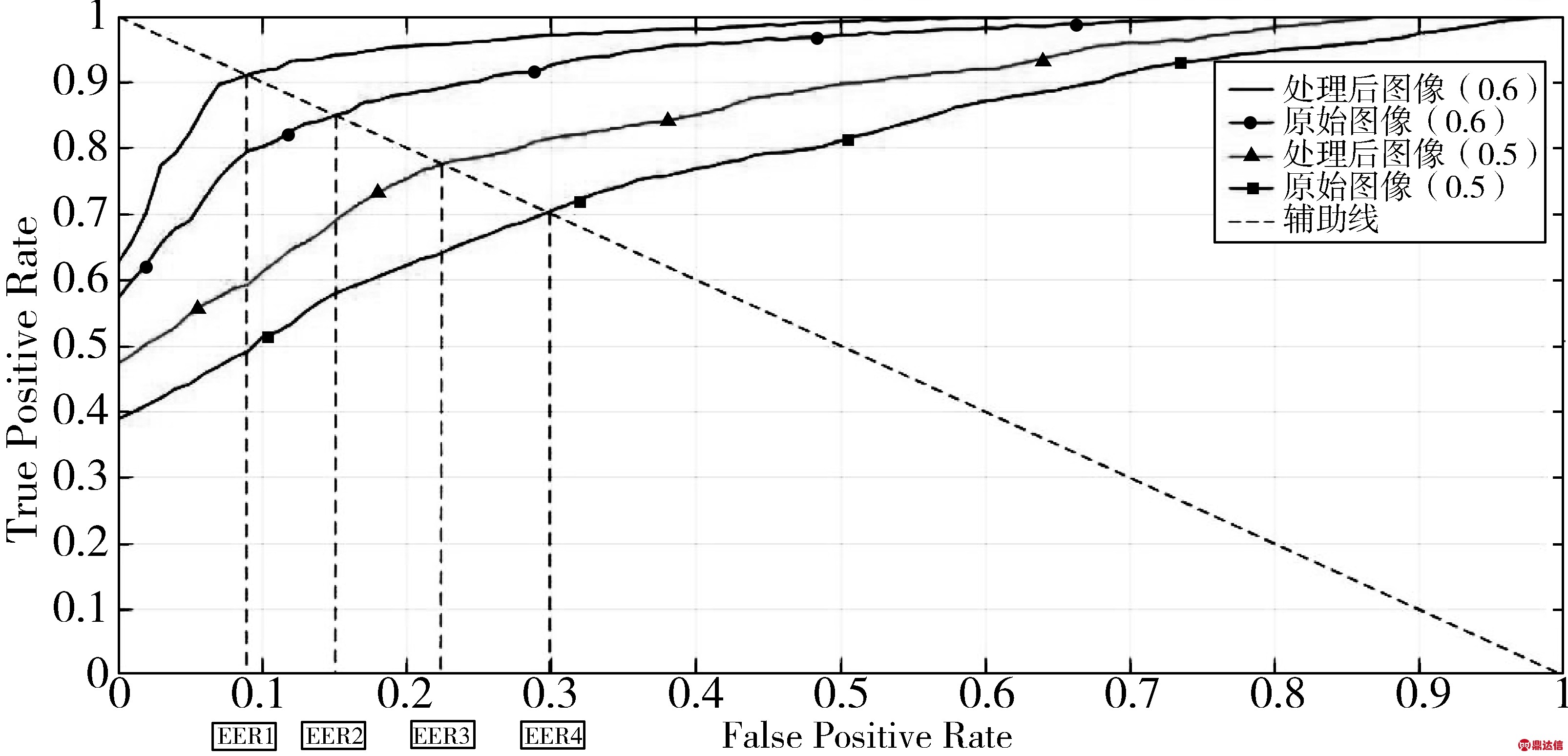

4.3 ROC曲线

ROC(Receiver Operating Characteristic)又称为感受性曲线(sensitivity curve),用来评价模型分类器的性能。横坐标为假阳率FPR(False Positive Rate),纵坐标为真阳率TPR(True Postive Rate)。

本文分别设置了阈值为0.5和0.6的情况,作出了原始图像模型和处理后图像模型的ROC曲线图,如图13所示。从图13可知:1)当FPR=0时,在2种阈值下,处理后图像模型比原始图像模型得到的TPR值都要高;2)对比4种情况下的等错误率EER(Equal Error Rate,即2类错误FP和FN相等时候的错误率),可以看出,在阈值相同的情况下,EER1>EER2,EER3>EER4;3)对比4种情况下曲线的AUC(Area Under Curve,即指曲线下的面积),可以看出在阈值相同的情况下,处理后图像模型面积始终大于原始图像模型面积。综上所述,处理后图像模型性能更好,性能更优越。

“化通”的过程包含了变化。作者以“通变论”总结了这一过程。作者指出,原诗和译诗之间是“一体”与“万化”、或者说“正”和“变”的关系。原诗到译诗的通变过程具有转化性、生成性、差异性、同一性和会通性。生成性是此过程的核心特性。在“反者道之动”这一通变机制的驱动下,诗言、诗意、通和变构成了诗歌翻译的意义生成结构。

图13 ROC曲线图

5 结束语

本文基于YOLOv3算法,提出了一种基于图像融合和YOLOv3的铝型材表面缺陷检测方法。利用图像增强、空域滤波的方法进行预处理,借鉴了SLAM中特征提取与匹配的思想进行图像融合,再通过K-means算法聚类和调参优化,最后利用物体检测模型YOLOv3对样本进行检测。通过修改网络架构和调参优化进行多次实验,得到了最优结果。实验结果表明:此图像融合与YOLOv3的方法对表面缺陷分类检出的平均成功率为98.33%,比单一YOLOv3方法提高了3.75个百分点;验证集mAP值为88.81%,提高了4.18个百分点,具有更强的特征提取能力和泛化能力。在今后的工作中,笔者将致力于压缩模型提升检测速度,使其更好地移植到小型便携的嵌入式系统中,这也是下一步研究的重点。